1.과소적합(underfitting)과 과대적합(overfitting)

모델이 데이터를 학습하는 과정에서 발생하는 과소적합, 과대적합 문제를 1) 모델 복합도 측면, 2) 데이터 정보량 측면에서 고려할 필요가 있음.

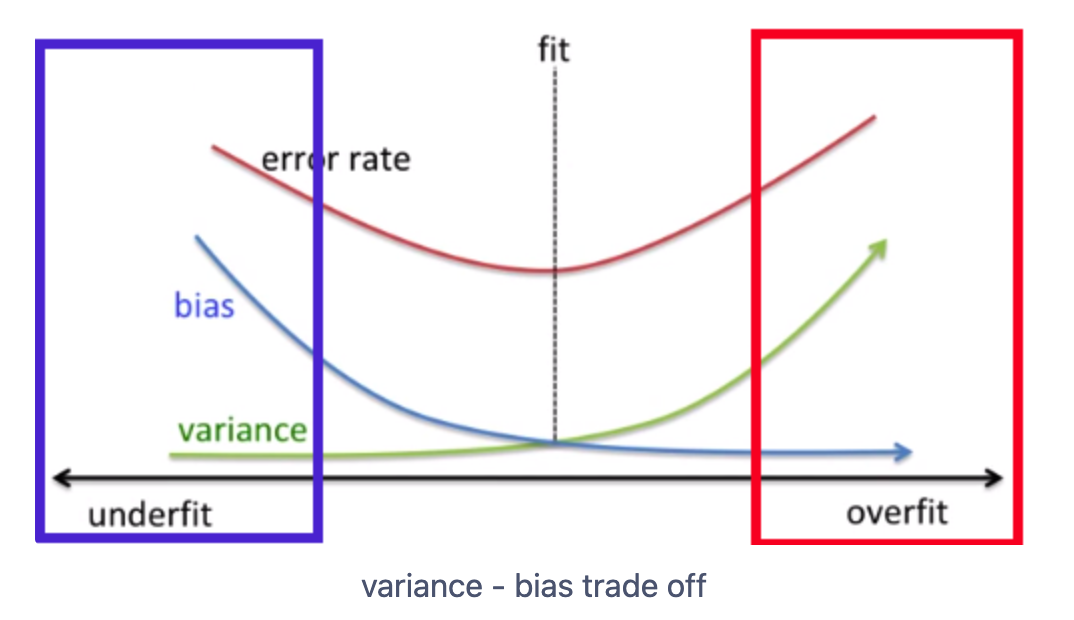

- 과소적합(underfitting): 학습 데이터조차 제대로 학습x(데이터 내재적인 구조 반영x), 편향이 높게(high bias) 학습되어 새로운 데이터를 예측하지 못하는 상태

- 과대적합(overfitting): 학습 데이터를 과하게 학습(지엽적인 특성까지 반영), 분산이 높게(high variance) 학습되어 새로운 데이터를 예측하지 못하는 상태

- 결론적으로, 편향을 높이면 학습이 잘 안되고, 편향이 낮으면 분산이 높아지는 절충(trade off) 관계로 두 가지 에러(error)를 최소화 할 수 있는 지점에서 모델의 복잡도가 결정될 때 모델의 좋은 성능을 기대할 수 있음

1) 모델 복합도 측면

2) 데이터 정보량 측면

주어진 데이터에는 모델링의 대상에 맞는 필요한 정보(signal), 불필요한 정보(noise), 상대적인 정보량이 존재. 모델링 대상을 정확하게 정의하고 보유한 데이터가 해당 대상을 명확하게 표현 하는데 충분한 정보량을 보유하고 있는지를 확인.

예를들어, 대출페이지 방문할 사람들을 찾는 모델을 만들겠다 → 필요한 정보를 탐색적 데이터 분석(EDA)

결론적으로, 주어진 데이터를 학습하여 새로운 데이터를 잘 예측하는 모델링 기법을 고려하는 것도 중요하지만, 데이터가 모델링에 필요한 정보량을 충분히 보유하고 있는지 확인 필요. 충분하지 않는 정보량의 데이터로는 모델의 복잡도를 조절하더라도 noise의 크기만 조절 되는 과소적합에서 벗어날 수 없음.

데이터의 정보량을 충분히 확보하는데 한계가 있는 상황이라면, 모델은 데이터 정보량에 따라 비슷한 성능을 보일것이고 예측 성능 차이가 크게 없다면 가장 단순한 모델이 시스템의 효율성 측면에서 좋은 모델.

*참고사항: 과소적합, 과대적합 해결방안

- 과소적합(underfitting)

- 모델 파라미터가 많은 복잡한 모델 고려

- 학습 데이터 확보

- 과대적합(overfitting)

- 적당한 복잡도 모델 고려

- 불필요한 노이즈 데이터 제거

- 정규화 제약

300x250

반응형

'Data Science > 머신러닝' 카테고리의 다른 글

| [머신러닝] ROC 커브, PR 커브 모델 성능 평가시 무엇을 언제 쓸까? (0) | 2023.06.27 |

|---|---|

| [PySpark] 5폴드 교차검증(5-fold crossvalidation) 과 모델선택 (0) | 2023.06.27 |

| [PySpark] 신용카드 사기거래 탐지 모델링(2) - 성능지표정의 (0) | 2023.06.22 |

| [PySpark] 신용카드 사기거래 탐지 모델링(1) - 데이터 탐색 (0) | 2023.06.21 |

| [머신러닝] 분류모델 성능지표 - 혼동행렬, AUC-ROC 커브, Lift/gain 차트 (1) | 2023.03.09 |